不懂医疗让很多医疗AI企业白瞎了投资!

昨日在健康界发了一篇长文,感觉内容有些长,在此放出缩略版。

在医学发展的长河中,我们正在见证历史!医学与AI的融合过程,将是一场前所未有的医疗服务范式重塑。

从19世纪的细菌学说,到21世纪的数字化革命,医学始终掌握在人类医生手中。然而,随着生成式人工智能和大语言模型的爆发,一种全新的“碳硅协同”态势正在形成。

这次转型,不再是技术的线性叠加,而是对医生“主体性”的根本考验。当AI穿上白大褂,人类医生是进化为更高阶的决策者,还是退化为算法的执行端?是医疗行业当前争论的热点。

2026年1月,复旦大学张文宏教授的一番言论在医学界和AI技术界同时激起千层浪。他明确拒绝将AI直接引入病历系统,核心理由直指痛点: 捍卫医生的“临床专业诊断能力”。

张教授揭示了一个关键认知:在“碳硅协同”的语境下,AI应当是医生的“外脑”(负责存储与检索),而非“大脑”(负责因果拆解与决策)。如果医生缺乏独立的洞察力和逻辑评判力,那么在诊疗过程中,他与一名手持高级医学账号的普通患者并无本质区别。

这也是当前医疗AI企业在推广产品时,面临的重大伦理风险。如果没有很好的定位,不能做好产品准备,促成与医学的双向奔赴,不管有多少亿资金支持,或者多强的算法能力,都是白瞎。

在高度心理压力的临床环境里,医生极易陷入对AI建议的过度依赖,忽略反直觉的证据,甚至放弃对原始数据的审查。一旦医生丧失了对算法输出的批判性评估能力,AI的“幻觉”将通过医生的权威被“合法化”,最终演变为系统性的医疗风险。

在过去,医生的权威建立在海量知识的记忆上。但在LLM时代,这一维度的竞争已无意义。根据《新英格兰医学杂志 AI》的观点,未来医生的核心胜任力必须发生迁移:从信息的“获取者”转变为信息的“管理者”与“批判者”。

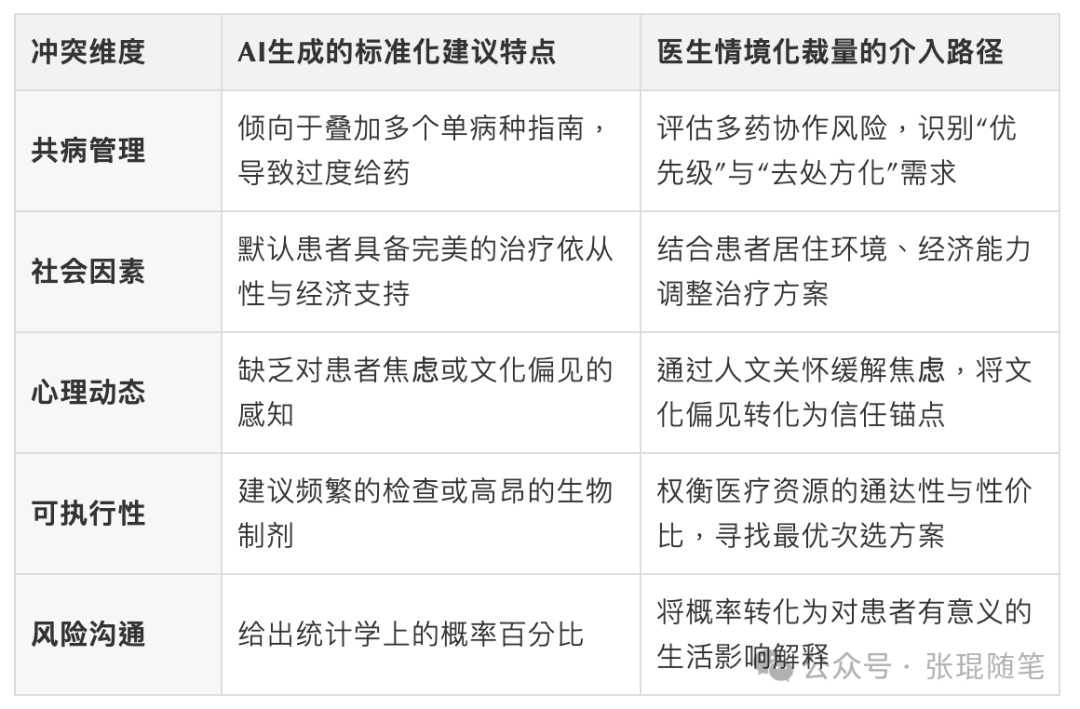

AI虽然强大,但它存在“锯齿状前沿”——可能在复杂的诊断推理上表现卓越,却在简单的逻辑判断上出现低级错误。因此, 医生必须掌握一种名为“情境化裁量”新的核心能力。

什么是情境化裁量?简而言之,AI负责提供“可能”(Possibility),而医生负责决定“可行”(Feasibility)。

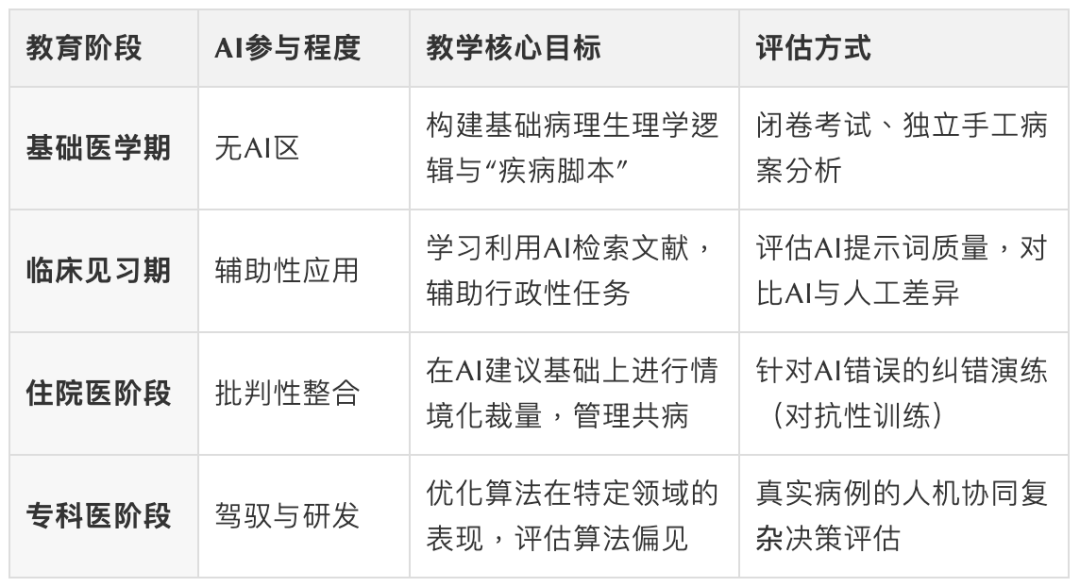

回到AI医疗的风险,如果在临床早期就过度依赖AI,会发生什么?张文宏教授提到了一个可怕概念:医学生的“认知萎缩”。

临床推理能力的形成,依赖于大脑中“疾病脚本”的反复刻画。如果医学生在早期直接利用AI获取诊断,就像小学生过早使用计算器导致心算能力退化一样,他们从症状到机理的逻辑链条将发生断裂。这种“逻辑外包”,会导致面对突发复杂情况时的“能力缺失”。

因此,医学教育急需建立一套适应未来医学范式的课程设计:

初阶设立“无AI区”:强制要求学生进行独立的逻辑推导,刻画稳固的疾病脚本。

未来的医学教育,不是教你怎么用AI查答案,而是教你如何成为算法的“审查官”。

而在未来的临床实践中,由于AI的介入,打破传统的“医生-患者”双元关系,必然会重构为“医生-AI-患者”的三元医疗模式。在这个新架构中,三方角色将重新定义:

AI负责“信息性支持”,处理数据与可视化;

医生回归“情感性支持”与“价值对齐”,成为有信任的专业桥梁;

患者带着AI生成的自诊报告,拥有了更强的依从性和主动健康意识。

患者对AI诊疗结果的信任,本质上是建立在“医生对AI具有掌控力”的认知之上的。医生必须能够清晰地解释:为什么参考了AI的建议?又为什么在某些环节推翻了AI的判断?

这种“人机担保”机制,要求医生具备更高维度的沟通技巧。如果医生只是简单地说“AI说你得了这个病”,那他也就丧失了作为人类医者的尊严。

张文宏教授的警示与医学界的反思共同指向了一个明确的未来: 技术的进步不应成为思维懒惰的温床,而应成为认知进化的阶梯。

碳硅协同时代的医学范式转型,核心不在于硅基算法有多强大,而在于碳基智能如何在算法的包围下实现更高维度的突围。我们需要的是具备深刻洞察力、严密逻辑拆解能力以及独立评价勇气的医生。

在人工智能日益成为医疗基础设施的今天,我们比任何时候都更需要回归医学的本质:那种在极度不确定性中,凭借人类的智慧、经验与慈悲心,为另一个生命做出负责任选择的专业精神。

唯有构建坚实的认知脚手架,重塑情境化裁量的胜任力,医学才能在碳硅协同的浪潮中,守住永恒的“医者仁心”。

BTW:打赏100元,加作者好友,进读者群。